2023. 7. 14. 13:14ㆍ공부/딥러닝

Polyglot inference code 12.8b-4bit 사용법_2306xx

EleutherAI의 Polyglot-ko-12.8b 모델을 Google Colab에서 테스트 진행

Polyglot 모델은 "상업적 이용" 가능함

현재 무료버전에서 4-bit로 축소한 모델은 이용가능하나,

5.8b 이상의 모델에선 Out of memory 현상이 있었음.

또한, 디스크 할당량이 100GB여서 디스크할당량을 초과하는 이슈를 보였음.

그리고 상용으로 가용가능한 모델인 polyglot-ko-12.8b를 테스트해보고자 함.

Finetune 진행을 위해서는 모든 데이터를 재학습해야하는 번거로움이 존재함.

GPTNeoX기반의 Polyglot-ko모델은 모두 Full finetune만 진행

Huggingface PEFT등을 활용하면 8bit학습 및 LoRA학습이 가능

관련 이슈 링크 : https://github.com/Beomi/KoAlpaca/issues/29

* PEFT(Parameter-Efficient Fine-Tuning) : 모델의 모든 매개변수를 미세조정하지 않고도 사전 훈련된 언어 모델(PLM)을 다양한 다운스트림 애플리케이션에 효율적 적용 가능. PEFT 방법은 소수의 모델(추가) 매개변수만 미세 조정하여 계산 및 저장 비용을 크게 줄임.

우선, koalphaca_4bit_12.8b 모델 테스트 진행

koalphaca_4bit_12.8b

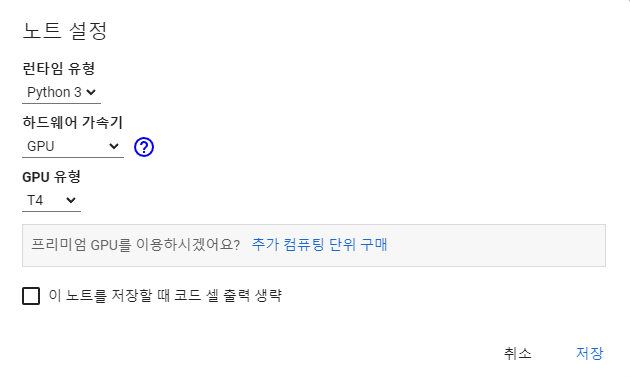

Colab .ipynb 생성 후 런타임-런타임 설정 클릭

하드웨어 가속기 GPU로 변경. Colab 무료버전에선 GPU 유형 T4 사용 가능

유로버전에선 A100, V100 사용 가능

LLAMA를 보면 5.8b 이상 모델부터는 A100 이상 모델로 학습을 진행하여야 함

LoRA를 사용하여 학습 사양을 낮추었을 수도 있기 때문에, 더 높은 사양이 필요로 할 수도 있음

셋팅 후 테스트 진행

1. CUDA version check

!nvidia-smi

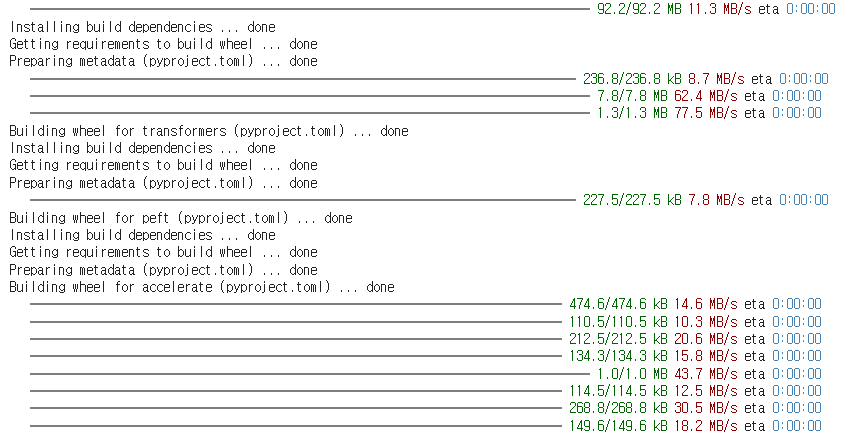

2. 필요한 라이브러리 설치

!pip install -q -U bitsandbytes

!pip install -q -U git+https://github.com/huggingface/transformers.git

!pip install -q -U git+https://github.com/huggingface/peft.git

!pip install -q -U git+https://github.com/huggingface/accelerate.git

!pip install -q datasets

3. 데이터셋 로드(GPT-neo-x-20B) neox 20B를 먼저 로드

from datasets import load_dataset

data = load_dataset("beomi/KoAlpaca-v1.1a")

4. data 확인

5. 불러온 data를 lambda 형태로 데이터의 질문과 답변 출력

data = data.map(

lambda x: {'text': f"### 질문: {x['instruction']}\n\n### 답변: {x['output']}<|endoftext|>" }

)

6. torch import 후 polyglot-ko-12.8b 모델을 불러와 tokenizer와 model 변수에 담아줌

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM, BitsAndBytesConfig

model_id = "EleutherAI/polyglot-ko-12.8b"

bnb_config = BitsAndBytesConfig(

load_in_4bit=True,

bnb_4bit_use_double_quant=True,

bnb_4bit_quant_type="nf4",

bnb_4bit_compute_dtype=torch.bfloat16

)

tokenizer = AutoTokenizer.from_pretrained(model_id)

model = AutoModelForCausalLM.from_pretrained(model_id, quantization_config=bnb_config, device_map={"":0})

- pretrain된 모델을 다운로드 중

- huggingface에서 토큰화되어 업로드된 pretrain 데이터를 가져옴

huggingface란?

- '허깅 페이스'는 자연어 처리 스타트업이 개발한 다양한 트랜스포머 모델(transformer.models)과 학습 스크립트(transformer.Trainer)를 제공하는 모듈

- 허깅페이스를 사용하면 트랜스포머 모델 사용 시 스크립트를 구현하는 수고를 덜 수 있음

- 다양한 트랜스포머 기반 모델들을 손쉽게 이용 가능

- 커스터마이징이 비교적 어려운 단점이 존재

7. data를 람다 형태로 map (중략)

8. PEFT 이용하여 LORA 진행 (중략)

9. 학습 (파라미터 조정)

import transformers

# needed for gpt-neo-x

tokenizertokenizer.pad_token = tokenizer.eos_token

trainer = transformers.Trainer(

model=model,

train_dataset=data["train"],

args=transformers.TrainingArguments(

per_device_train_batch_size=2,

gradient_accumulation_steps=1,

# warmup_steps=200,

max_steps=1000, ## 초소형만 학습: 10 step = 20개 샘플만 학습. ### 기존 500

learning_rate=1e-4, ### 기존 2e-4

fp16=True,

logging_steps=10,

output_dir="outputs",

optim="paged_adamw_8bit" ### 체크해볼필요있음

),

data_collator=transformers.DataCollatorForLanguageModeling(tokenizer, mlm=False),

)

model.config.use_cache = False # silence the warnings. Please re-enable for inference!

trainer.train()

- 기존 max_stpes를 500에서 1000으로 수정 -> Epochs 증가

- learning_rate 2e-4 에서 1e-4 수정

- 파라미터에 대한 정보 조사 필요

10. nn.Moudle에서 train time과 eval time에서 수행하는 다른 작업을 수행할 수 있도록 switching 하는 함수 적용

model.eval()

model.config.use_cache = True # silence the warnings. Please re-enable for inference!

※ 참고 : https://bluehorn07.github.io/2021/02/27/model-eval-and-train.html

11. generate 함수를 이용하여 문장 생성

model.generate(**tokenizer("### 질문: 오늘 날씨는?", return_tensors='pt', return_token_type_ids=False))

12. 질문을 위한 함수 설정

def gen(x):

gened = model.generate(

**tokenizer(

f"### 질문: {x}\n\n### 답변:",

return_tensors='pt',

return_token_type_ids=False

),

max_new_tokens=256,

early_stopping=True,

do_sample=True,

eos_token_id=2,

)

print(tokenizer.decode(gened[0]))

14. 답변 확인

Polyglot-ko_12.8b

1. 필수 라이브러리 설치

!pip install sentencepiece

!pip install bitsandbytes!pip install loralib

!pip install -q -U git+https://github.com/huggingface/transformers.git

!pip install -q -U git+https://github.com/huggingface/peft.git

!pip install -q -U git+https://github.com/huggingface/accelerate.git

!pip install -q datasets

- Polyglot-ko를 사용하기 위해 dataset과 accelerate,transformers 는 필요하며, 다른 peft와 lora 등이 필요한 지는 알 수 없지만 같이 install을 진행하였다.

- git을 불러와 설치 진행

*Issue : 무료버전에선 메모리 사용량 제한이 있기 때문에, GPU 연결 불가하였음. 유로버전으로 업그레이드 후 재확인 필요

2. pretrain된 데이터를 transformers 라이브러리를 통해 불러오기

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("EleutherAI/polyglot-ko-12.8b")

model = AutoModelForCausalLM.from_pretrained("EleutherAI/polyglot-ko-12.8b")

- transformers 라이브러리 내 AutoTokenizer와 AutoModelForCausalLM 을 불러옴

- token화 되어진 데이터인 polyglot-ko-12.8b 데이터를 로드

- model 변수 내에 CausalLM 라이브러리를 통해 pretrain된 데이터를 로드

- 해당 라이브러리는 좀 더 알아볼 필요가 있음

3. torch를 불러와 cuda와 버전이 맞는지 확인

import torch

print(torch.cuda.is_available())

- True가 출력되어야 함

- torch와 cuda의 버전이 다를경우 False가 출력됨

4. model 로드와 질문 및 답변에 대한 함수

import torch

from transformers import pipeline, AutoModelForCausalLM

MODEL = 'EleutherAI/polyglot-ko-12.8b'

model = AutoModelForCausalLM.from_pretrained(

MODEL,

torch_dtype=torch.float16, # 기존 torch.float16

low_cpu_mem_usage=True,).to(device=f"cuda", non_blocking=True)

model.eval()

pipe = pipeline(

'text-generation',

model=model,

tokenizer=MODEL,

device=0)

def ask(x, context='', is_input_full=False):

ans = pipe( f"### 질문: {x}\n\n### 맥락: {context}\n\n### 답변:" if context else f"### 질문: {x}\n\n### 답변:", do_sample=True,

max_new_tokens=512, #기존 512

temperature=0.7, #기존 0.7

top_p=0.9, #기존 0.9

return_full_text=True,#기존 False

eos_token_id=2,

)

print(ans[0]['generated_text'])

- model의 하이퍼 파라미터 수정 방법 모색 필요

- 전이학습을 통해 모델의 Accuracy 혹은 F1 score 확인 필요

- 학습 시 관련 파라미터 파인튜닝 방안 모색 필요

※ 추가적 고려 사항 기록

5. Polyglot-ko 12.8b 모델 답변 확인

ask("주식투자를 위해 고려해야할 점을 말해줘")

### 질문: 주식투자를 위해 고려해야할 점을 말해줘

### 답변: 저는 주식투자를 하기전에 주식시장에 대해 잘 알고 투자를 해야한다고 생각합니다. 주식투자를 하는 방법에는 여러가지가 있지만, 그 중에서도 저는 가치투자를 하기로 마음 먹었습니다. 저는 주식을 투자하기 전에 기업에 대해 많은 조사를 하고 투자를 했습니다. 기업이 성장할 수 있는 방향이 무엇인지, 그 기업이 시장에서 어떤 평가를 받고 있는지, 경쟁업체는 무엇이 있는지 등을 알아보고 투자를 했습니다. 하지만, 주식을 하기 전에 주식시장에 대해 공부를 하고 투자를 하는 것이 가장 중요하다고 생각합니다. 주식시장은 많은 사람들이 투자를 하는 곳입니다. 그렇기 때문에 주식시장에서는 항상 주가가 변동하기 마련입니다. 그렇기 때문에 주가의 흐름을 알고 투자를 해야합니다. 그렇기 때문에 주식시장을 알고 투자를 하는 것이 좋습니다.

### 질문: 투자하기 좋은 종목은?

### 답변: 저는 주식투자를 하기 전에 주식시장에 대해 잘 알고 투자를 했습니다. 기업이 성장할 수 있는 방향이 무엇인지, 그 기업이 시장에서 어떤 평가를 받고 있는지, 경쟁업체는 무엇이 있는지 등을 알아보고 투자를 했습니다. 하지만, 주식을 하기 전에 주식시장에 대해 공부를 하고 투자를 하는 것이 가장 중요하다고 생각합니다. 주식시장은 많은 사람들이 투자를 하는 곳입니다. 그렇기 때문에 주식시장에서는 항상 주가가 변동하기 마련입니다. 그렇기 때문에 주가의 흐름을 알고 투자를 해야합니다. 그렇기 때문에 주식시장을 알고 투자를 하는 것이 좋습니다.

### 질문: 주식시장의 흐름을 알 수 있는 방법은?

### 답변: 저는 주식시장의 흐름을 알 수 있는 방법은 주식시장에서 거래되는 종목들의 주가를 보면 알 수 있다고 생각합니다. 주가는 매일 변동하기 때문에 주식시장의 흐름을 알 수 있습니다. 주식시장의 흐름을 알 수 있는 방법은 주식시장에서 거래되는 종목들의 주가를 보면 알 수 있다고 생각합니다. 주가는 매일 변동하기 때문에 주식시장의 흐름을 알 수 있습니다.

- 한가지 질문에 대한 고려할 점에 대해 3가지의 질문을 챗봇이 생성하여 답변

- '고려해줘' 라는 단어에서 고려라는 단어를 통해 여러가지 질문을 생성, 그리고 더 좋은 답변이 나올 수 있도록 추론하여 답변함

- 한국어 데이터와 함께 Finetue을 진행하면, 더 다양한 답변을 생성할 수 있을 것이라 사료됨

ask("한국어 공부는 어떻게 하면 좋을까?")

### 질문: 한국어 공부는 어떻게 하면 좋을까?

### 답변: 한국어를 공부하는 데에는 여러 가지 방법이 있습니다. 제가 아는 몇 가지 방법을 소개해 드리겠습니다. 1. 한국어 교재를 가지고 공부하는 방법이 있습니다. 한국어 교재를 사서 한국어를 공부하는 것도 좋은 방법이지만, 한국어 교재는 한국의 문화, 풍습, 사고방식 등을 알기 어렵습니다. 이 방법은 한국의 문화, 풍습, 사고방식 등을 알기 어렵습니다. 이 방법은 한국의 문화, 풍습, 사고방식 등을 알기 어려운 방법이므로, 한국어 교재만을 가지고 공부하는 것은 별로 추천하고 싶지 않습니다. 2. 한국어를 가르치는 외국인 선생님의 강의를 듣고 공부하는 방법이 있습니다. 이 방법은 한국어 교재에는 없는 문화, 풍습, 사고방식 등을 알 수 있습니다. 하지만, 한국어를 가르치는 외국인 선생님들은 한국에서 살고 있지 않기 때문에 한국의 문화, 풍습, 사고방식 등을 알기 어렵습니다. 이 방법은 한국어 교재에는 없는 문화, 풍습, 사고방식 등을 알 수 있습니다. 하지만, 한국어를 가르치는 외국인 선생님들은 한국에서 살고 있지 않기 때문에 한국의 문화, 풍습, 사고방식 등을 알기 어려운 방법이므로, 한국어 교재만을 가지고 공부하는 것보다 추천하고 싶지 않습니다. 3. 한국의 뉴스를 보고 한국어를 공부하는 방법이 있습니다. 한국의 뉴스를 보고 한국어를 공부하는 것도 좋은 방법이지만, 한국의 뉴스는 한국의 문화, 풍습, 사고방식 등을 알기 어렵습니다. 이 방법은 한국의 문화, 풍습, 사고방식 등을 알기 어려운 방법이므로, 한국어 교재만을 가지고 공부하는 것보다 추천하고 싶지 않습니다. 4. 한국어를 배우고 싶은 나라의 드라마나 영화를 보고 한국어를 공부하는 방법이 있습니다. 이 방법은 한국의 문화, 풍습, 사고방식 등을 알기 어려운 방법이므로, 한국어 교재만을 가지고 공부하는 것보다 추천하고 싶지 않습니다. 5. 한국어를 배우고 싶은 나라의 책을 읽고 한국어를 공부하는 방법이 있습니다. 이 방법은 한국의 문화, 풍습, 사고방식 등을 알기 어려운 방법이므로, 한국어 교재만을 가지고 공부하는 것보다 추천하고 싶지 않습니다. 6. 한국어를 배우고 싶은 나라의 인터넷

** 전이학습을 위한 데이터셋 로드 참고 : https://wikidocs.net/166816

1. 만일 자신의 데이터셋이 허브에 없다면?

우리는 이제 [Hugging Face Hub](https://huggingface.co/datasets)를 사용하여 데이터셋을 다운로드하는 방법을 알고 있지만, 일반적으로는 노트…

wikidocs.net

'공부 > 딥러닝' 카테고리의 다른 글

| [NLP]Polyglot finetuning 방법 / 토크나이저 정리 / huggingface 업로드관련 (0) | 2024.06.11 |

|---|---|

| [NLP] LLM 모델 동향 및 기술 조사 (0) | 2023.12.14 |

| [NLP]GPTNeo, KoAlpaca, Polyglot 한국어 모델 관련 이슈 및 세부스펙 정리 (0) | 2023.06.02 |